该公司的新免费旗舰产品“omnimodel”看起来就像 Siri 或 Alexa 等助手的增强版。

OpenAI 刚刚推出了 GPT-4o,这是一种新型 AI 模型,您可以通过实时语音对话、手机视频流和文本进行实时通信。该公司表示,该模型将在未来几周内推出,并将通过 GPT 应用程序和网络界面免费向所有用户开放。订阅 OpenAI 付费套餐(每月 20 美元起)的用户将能够提出更多请求。

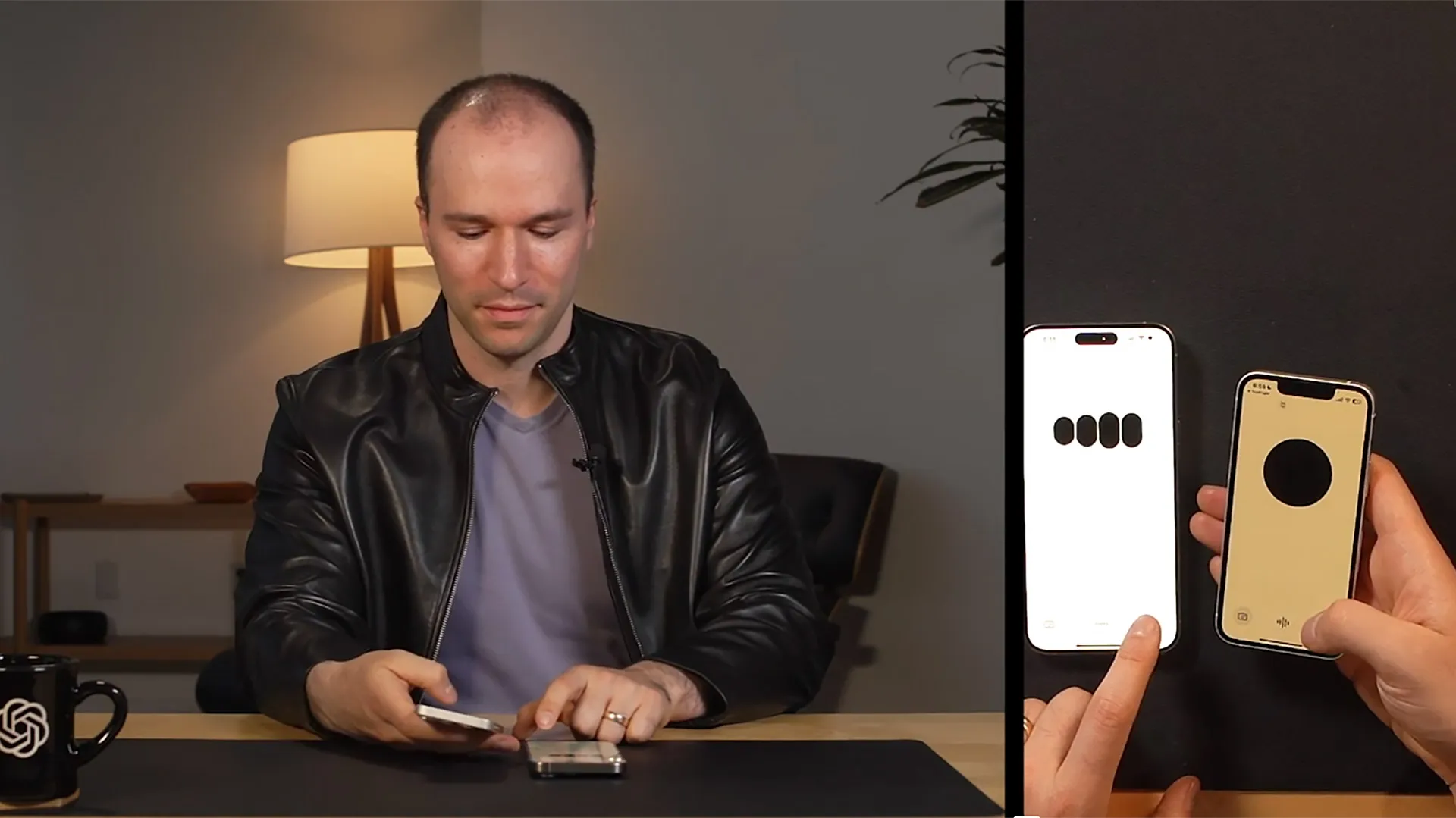

OpenAI 首席技术官 Mira Murati 现场演示了新版本,预计谷歌将在 5 月 14 日星期二的旗舰 I/O 大会上公布自己的人工智能进展。

GPT-4 提供了类似的功能,为用户提供了多种与 OpenAI 的 AI 产品交互的方式。但它将它们隔离在不同的模型中,导致响应时间更长,计算成本可能更高。 GPT-4o 现在已将这些功能合并到一个模型中,Murati 称之为“全模型”。她说,这意味着任务之间的响应速度更快,过渡更顺畅。

该公司的演示表明,其结果是一款类似于 Siri 或 Alexa 的对话助理,但能够处理更复杂的提示。

“我们正在研究我们自己与机器之间交互的未来,”穆拉蒂在谈到演示时说道。 “我们认为 GPT-4o 确实正在将这种范式转变为协作的未来,使这种交互变得更加自然。”

OpenAI 的研究人员 Barret Zoph 和 Mark Chen 介绍了新模型的一些应用。最令人印象深刻的是它的现场对话设施。你可以在模型响应期间打断它,它会停下来、倾听并调整路线。

OpenAI 还展示了改变模型基调的能力。陈要求模特读一个“关于机器人和爱情”的睡前故事,并迅速插话要求模特发出更戏剧化的声音。该模型逐渐变得更加戏剧化,直到穆拉蒂要求它快速转向令人信服的机器人声音(它擅长这一点)。虽然在模型推理接下来要说什么的过程中,对话过程中出现了一些短暂的停顿,但它作为一场节奏非常自然的人工智能对话脱颖而出。

该模型还可以实时通过视觉问题进行推理。 Zoph 使用手机拍摄了自己在一张纸上写下代数方程 (3 x + 1 = 4) 的过程,GPT-4o 也跟着进行。他指示它不要提供答案,而是像老师一样指导他。

“第一步是获得一侧带有x的所有项,”模型以友好的语气说道。 “那么,你认为我们应该用这个加一做什么?”

与前几代 GPT 一样,GPT-4o 将存储用户与其交互的记录,这意味着该模型“在所有对话中具有连续性”,Murati 表示。其他新亮点包括实时翻译、搜索与模特对话的能力以及实时查找信息的能力。

由于现场演示的本质,存在一些小问题和小故障。在谈话过程中,GPT-4o 的声音可能会尴尬地插入。它似乎对其中一位主持人的着装进行了评论,尽管它没有被要求这样做。但当示威者告诉模型它犯了错误时,它恢复得很好。它似乎能够跨多种媒介做出快速而有益的响应,而其他模型尚未有效地融合。

此前,OpenAI 的许多最强大的功能(例如通过图像和视频进行推理)都是付费的。 GPT-4o 标志着它们首次向更广泛的公众开放,尽管目前尚不清楚在收费之前您可以与该模型进行多少次交互。 OpenAI 表示,付费用户的容量限制将“继续达到免费用户的五倍”。

威尔·道格拉斯·天堂的补充报道。

更正:这个故事已经更新,以反映存储过去对话的内存功能对于 GPT-4o 来说并不新鲜,而是存在于以前的模型中。

发表评论