Stability AI 推出了Stable LM 2 语言模型系列的最新成员:一个 120 亿参数的基础模型和一个指令调整的变体。这些模型接受了跨七种语言的令人印象深刻的 2 万亿个标记的训练:英语、西班牙语、德语、意大利语、法语、葡萄牙语和荷兰语。

120 亿参数模型旨在在强大的性能、效率、内存需求和速度之间取得平衡。它遵循 Stability AI 之前发布的 Stable LM 2 1.6B 技术报告的既定框架。这一新版本扩展了公司的模型范围,为开发人员提供了透明且强大的工具,用于利用人工智能语言技术进行创新。

除了 12B 模型外,Stability AI 还发布了 Stable LM 2 1.6B 模型的新版本。此更新的 1.6B 变体提高了跨相同七种语言的对话能力,同时保持了非常低的系统要求。

Stable LM 2 12B 被设计为专为多语言任务量身定制的高效开放模型,在广泛可用的硬件上具有流畅的性能。

根据 Stability AI 的说法,该模型可以处理通常仅适用于较大模型的任务,这些模型通常需要大量计算和内存资源,例如大型专家混合 (MoE)。由于其在工具使用和函数调用方面的高性能,指令调整版本特别适合各种用途,包括作为检索 RAG 系统的核心部分。

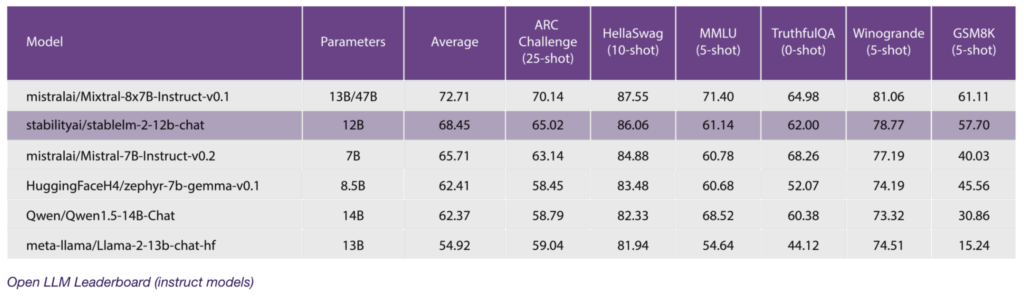

在与 Mixtral、Llama2、Qwen 1.5、Gemma 和 Mistral 等流行的强语言模型进行性能比较时,Stable LM 2 12B 在 Open LLM 排行榜中概述的一般基准上进行零样本和少样本任务测试时提供了可靠的结果:

通过这个新版本,Stability AI 将 StableLM 2 系列扩展到 12B 类别,提供开放透明的模型,同时不影响功能和准确性。该公司相信,此版本将使开发人员和企业能够继续开发未来,同时保留对其数据的完全控制。

开发人员和企业现在可以通过Stability AI 会员资格将 Stable LM 2 12B 用于商业和非商业目的。