在许多高风险情况下,大型语言模型不值得冒险。知道要丢弃哪些输出可能会解决这个问题。

大型语言模型以其编造能力而闻名——事实上,这正是它们最擅长的。但它们无法区分事实与虚构,这让许多企业怀疑是否值得冒险使用它们。

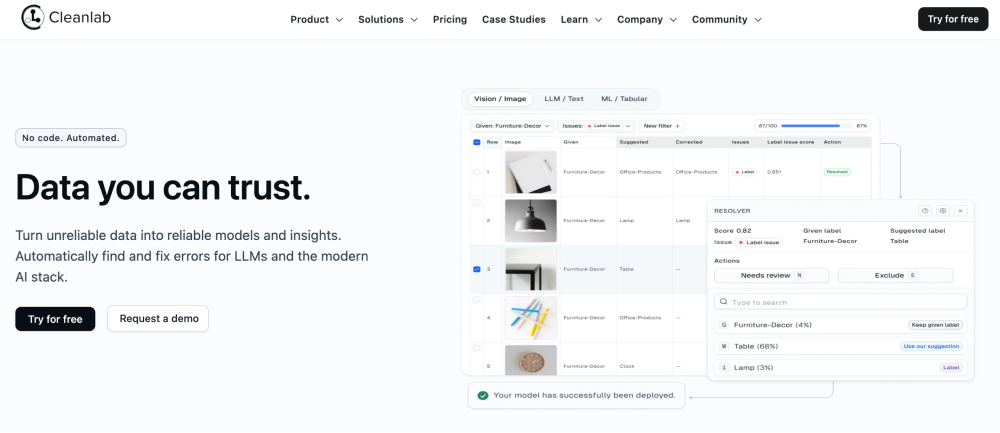

Cleanlab 是一家从麻省理工学院量子计算实验室衍生出来的人工智能初创公司,它创建了一款新工具,旨在让高风险用户更清楚地了解这些模型的真实可信度。它被称为“可信语言模型”,根据其可靠性,为大型语言模型生成的任何输出提供 0 到 1 之间的分数。这让人们可以选择信任哪些回应以及丢弃哪些回应。换句话说:聊天机器人的 BS-o-meter。

Cleanlab 希望它的工具能够让大型语言模型对那些担心自己发明了多少东西的企业更具吸引力。 “我认为人们知道法学硕士将改变世界,但他们只是沉迷于该死的幻觉,”Cleanlab 首席执行官柯蒂斯·诺斯卡特 (Curtis Northcutt) 说。

聊天机器人正迅速成为人们在计算机上查找信息的主要方式。搜索引擎正在围绕该技术进行重新设计。数十亿人每天使用办公软件来创建从学校作业到营销文案再到财务报告的所有内容,现在内置了聊天机器人。然而,由谷歌前员工创立的初创公司 Vectara 在 11 月发布的一项研究发现,聊天机器人至少有 3% 的时间在发明信息。这听起来可能不多,但大多数企业都不会容忍这种潜在的错误。

Cleanlab 的工具已经被少数公司使用,其中包括伯克利研究集团(Berkeley Research Group),这是一家专门从事企业纠纷和调查的英国咨询公司。伯克利研究小组副主任 Steven Gawthorpe 表示,可信语言模型是他见过的第一个解决幻觉问题的可行解决方案:“Cleanlab 的 TLM 为我们提供了数千名数据科学家的力量。”

2021 年,Cleanlab 开发的技术发现了用于训练机器学习算法的34 个流行数据集的错误;它的工作原理是测量一系列基于该数据训练的模型的输出差异。这项技术现在被几家大公司使用,包括谷歌、特斯拉和银行巨头大通银行。可信语言模型采用相同的基本思想——模型之间的分歧可以用来衡量整个系统的可信度——并将其应用于聊天机器人。

在 Cleanlab 上周向《麻省理工科技评论》提供的演示中,Northcutt 在 ChatGPT 中输入了一个简单的问题:“字母‘n’在‘enter’中出现了多少次?” ChatGPT 回答:“字母‘n’在‘输入’一词中出现一次。”正确的答案可以促进信任。但再问几次这个问题,ChatGPT 就会回答:“字母‘n’在‘enter’这个词中出现了两次。”

“它不仅经常出错,而且是随机的,你永远不知道它会输出什么,”Northcutt 说。 “为什么它不能直接告诉你它一直输出不同的答案呢?”

Cleanlab 的目标是让这种随机性更加明确。 Northcutt 向可信语言模型提出了同样的问题。 “字母‘n’在‘enter’这个词中出现了一次”,它的答案是 0.63。满分 10 分中的 6 分并不是一个很好的分数,这表明聊天机器人对这个问题的回答不应该被信任。

这是一个基本的例子,但它说明了要点。诺斯卡特说,如果没有分数,你可能会认为聊天机器人知道它在说什么。问题在于,在高风险情况下测试大型语言模型的数据科学家可能会被一些正确答案所误导,并假设未来的答案也将是正确的:“他们尝试了一些事情,他们尝试了一些例子,他们认为这有效。然后他们做出的事情会导致非常糟糕的商业决策。”

可信语言模型利用多种技术来计算其分数。首先,提交给该工具的每个查询都会被发送到几个不同的大型语言模型。 Cleanlab 使用五个版本的 DBRX,这是由位于旧金山的人工智能公司 Databricks 开发的开源模型。 (但 Northcutt 表示,该技术适用于任何模型,包括 Meta 的 Llama 模型或 OpenAI 的 GPT 系列,即 ChatpGPT 背后的模型。)如果每个模型的响应相同或相似,它将有助于获得更高的分数。

同时,可信语言模型还将原始查询的变体发送到每个 DBRX 模型,交换具有相同含义的单词。同样,如果对同义查询的响应相似,则将有助于获得更高的分数。 “我们以不同的方式与他们打交道,以获得不同的输出,看看他们是否同意,”诺斯卡特说。

该工具还可以让多个模型相互反馈:“就像是,‘这是我的答案——你觉得怎么样?’” “好吧,这是我的——你觉得怎么样?”然后你让他们说话。”这些相互作用被监控和测量,并被输入到分数中。

英国剑桥微软研究院的计算机科学家 Nick McKenna 致力于研究用于代码生成的大型语言模型,他乐观地认为这种方法可能有用。但他怀疑这是否会是完美的。 “我们在模型幻觉中看到的陷阱之一是它们可以非常巧妙地潜入,”他说。

在针对不同大型语言模型的一系列测试中,Cleanlab 表明其可信度分数与这些模型响应的准确性密切相关。换句话说,接近 1 的分数对应正确的答案,接近 0 的分数对应错误的答案。在另一项测试中,他们还发现将可信语言模型与 GPT-4 结合使用比单独使用 GPT-4 产生更可靠的响应。

大型语言模型通过预测序列中最可能的下一个单词来生成文本。在其工具的未来版本中,Cleanlab 计划通过利用模型进行预测的概率来使其分数更加准确。它还希望访问模型分配给词汇表中每个单词的数值,用于计算这些概率。这种级别的详细信息由某些平台(例如亚马逊的 Bedrock)提供,企业可以使用该平台来运行大型语言模型。

Cleanlab 已根据伯克利研究小组提供的数据测试了其方法。该公司需要在数以万计的公司文件中搜索有关医疗保健合规问题的参考资料。手工完成此操作可能需要熟练员工花费数周的时间。通过使用可信语言模型检查文档,伯克利研究小组能够了解聊天机器人对哪些文档最不信任,并仅检查那些文档。 Northcutt 表示,它减少了大约 80% 的工作量。

在另一项测试中,Cleanlab 与一家大型银行合作(Northcutt 不愿透露具体名称,但表示它是高盛的竞争对手)。与 Berkeley Research Group 类似,该银行需要在大约 100,000 份文件中搜索保险索赔的参考信息。值得信赖的语言模型再次将需要手动检查的文档数量减少了一半以上。

通过多个模型多次运行每个查询比使用单个聊天机器人进行典型的来回操作需要更长的时间和更高的成本。但 Cleanlab 将可信语言模型定位为一项高级服务,用于自动执行高风险任务,而这些任务在过去是大型语言模型无法完成的。这个想法并不是要取代现有的聊天机器人,而是要完成人类专家的工作。 Northcutt 表示,如果该工具能够以每小时 2,000 美元的价格减少您雇用熟练经济学家或律师所需的时间,那么这些成本就是值得的。

从长远来看,Northcutt 希望通过减少聊天机器人响应的不确定性,他的技术将为更广泛的用户释放大型语言模型的希望。 “幻觉问题并不是一个大的语言模型问题,”他说。 “这是一个不确定性问题。”

发表评论