生成式人工智能使得网络钓鱼、诈骗和人肉搜索变得比以往任何时候都更加容易。

人工智能极大地提高了犯罪黑社会的生产力。

安全公司趋势科技的高级威胁研究员 Vincenzo Ciancaglini 表示,生成式 AI 提供了一个新的、强大的工具包,使恶意行为者能够比以往更高效、更国际化地开展工作。

钱卡利尼说,大多数犯罪分子“并不是生活在黑暗的巢穴里密谋行事”。 “他们中的大多数人都是普通人,从事的日常活动也需要生产力。”

去年见证了WormGPT的兴起和衰落,这是一种建立在开源模型之上的人工智能语言模型,并接受恶意软件相关数据的训练,其创建目的是帮助黑客,没有道德规则或限制。但去年夏天,该模型的创建者在该模型开始吸引媒体关注后宣布他们将关闭该模型。从那时起,网络犯罪分子大多停止开发自己的人工智能模型。相反,他们选择使用可靠工作的现有工具来解决问题。

钱卡利尼解释说,这是因为犯罪分子想要轻松的生活和快速的收益。对于任何新技术来说,要值得承担与采用它相关的未知风险(例如,被抓住的更高风险),它必须比他们目前使用的技术更好并带来更高的回报。

以下是犯罪分子目前使用人工智能的五种方式。

网络钓鱼

苏黎世联邦理工学院的人工智能安全研究员米斯拉夫·巴卢诺维奇 (Mislav Balunović) 表示,目前犯罪分子中生成式人工智能的最大用例是网络钓鱼,其中涉及试图诱骗人们泄露可用于恶意目的的敏感信息。研究人员发现,ChatGPT 的兴起伴随着网络钓鱼电子邮件数量的大幅增加。

Ciancaglini 表示,GoMail Pro 等垃圾邮件生成服务已集成 ChatGPT,这使得犯罪用户能够翻译或改进发送给受害者的消息。 Ciancaglini 表示,OpenAI 的政策限制人们使用其产品进行非法活动,但这在实践中很难监管,因为许多听起来无辜的提示也可能被用于恶意目的。

OpenAI 表示,它使用人工审核员和自动化系统相结合来识别和强制防止其模型的滥用,如果用户违反公司政策,则会发出警告、临时暂停和禁令。

OpenAI 的一位发言人告诉我们:“我们认真对待产品的安全性,并根据人们使用我们产品的方式不断改进我们的安全措施。”他们补充道:“我们不断努力使我们的模型更安全、更强大,防止滥用和越狱,同时保持模型的实用性和任务性能。”

OpenAI 在 2 月份的一份报告中表示,它已经关闭了五个与国家附属恶意行为者相关的账户。

Ciancaglini 表示,以前,所谓的尼日利亚王子骗局,即有人向受害者承诺一大笔钱,以换取小额预付款,这种骗局相对容易被发现,因为消息中的英文很笨拙,而且充满语法错误。 。说。语言模型允许诈骗者生成听起来像母语人士所写的消息。

“过去,说英语的人相对不会受到非英语[犯罪分子]的威胁,因为你可以发现他们的信息,”钱卡利尼说。现在情况已不再是这样了。

得益于更好的人工智能翻译,世界各地的不同犯罪集团也可以更好地相互沟通。钱卡利尼说,风险在于他们可能会协调跨越本国的大规模行动,并针对其他国家的受害者。

Deepfake 音频诈骗

生成式人工智能让深度伪造技术的发展取得了巨大的飞跃,合成图像、视频和音频看起来和听起来都比以往更加逼真。这引起了犯罪界的注意。

据报道,今年早些时候,香港一名员工被骗走 2500 万美元,原因是网络犯罪分子利用公司首席财务官的 Deepfake 说服该员工将钱转入诈骗者的账户。 “我们已经看到深度赝品最终在地下销售,”钱卡利尼说。他的团队发现,人们在 Telegram 等平台上展示他们的 Deepfakes“组合”,并以每张图片 10 美元或每分钟 500 美元的价格出售他们的服务。钱卡利尼说,埃隆·马斯克是最受犯罪分子深度伪造的人之一。

虽然深度造假视频制作起来仍然很复杂,而且人类更容易发现,但音频深度造假的情况却并非如此。它们的制作成本低廉,并且只需要几秒钟的某人的声音(例如从社交媒体获取)即可生成令人难以置信的令人信服的内容。

在美国,曾有一些引人注目的案例,人们接到亲人打来的令人痛苦的电话,称自己被绑架了,并要求释放钱财,结果发现打电话的人是一个使用深度伪造语音录音的骗子。 。

“人们需要意识到,现在这些事情都是可能的,人们需要意识到,现在尼日利亚国王不再用蹩脚的英语说话了,”钱卡利尼说。 “人们可以用另一种声音给你打电话,他们会让你处于非常紧张的境地,”他补充道。

他说,有些是为了人们保护自己。钱卡利尼建议亲人之间商定定期更换的秘密安全词,这有助于确认电话另一端的人的身份。

“我用密码保护了我的祖母,”他说。

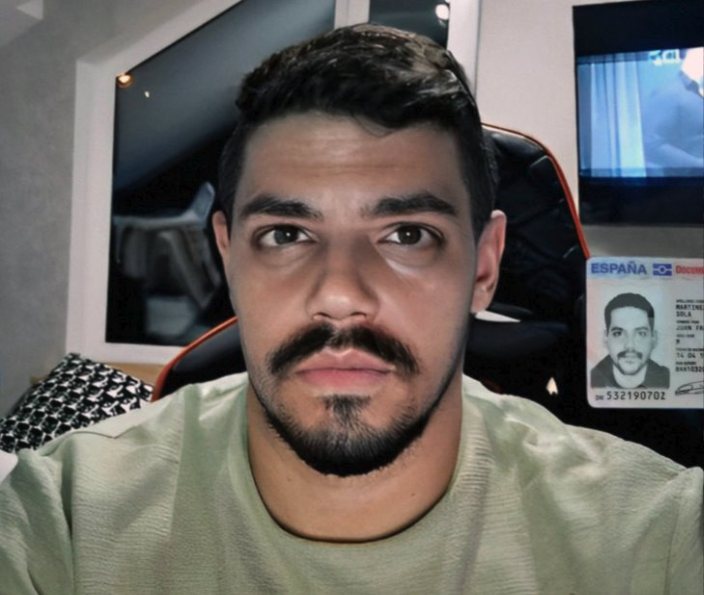

绕过身份检查

犯罪分子使用深度伪造的另一种方式是绕过“了解你的客户”验证系统。银行和加密货币交易所使用这些系统来验证他们的客户是否是真实的人。他们要求新用户在镜头前手持实物身份证件拍一张自己的照片。但犯罪分子已经开始在 Telegram 等平台上销售允许人们绕过这一要求的应用程序。

他们的工作方式是提供虚假或被盗的身份证件,并将深度伪造的图像强加在真人的脸上,以欺骗 Android 手机相机上的验证系统。 Ciancaglini 发现了一些例子,人们以低至 70 美元的价格为加密货币网站 Binance 提供这些服务。

“这些技术还很基础,”Ciancaglini 说。他们使用的技术类似于 Instagram 滤镜,将别人的脸换成你自己的脸。

“我们未来可以预期的是,[犯罪分子]将使用真正的深度伪造……这样你就可以进行更复杂的身份验证,”他说。

越狱即服务

如果你问大多数人工智能系统如何制造炸弹,你不会得到有用的答复。

这是因为人工智能公司已经采取了各种保护措施来防止他们的模型泄露有害或危险的信息。网络犯罪分子不再在没有这些保障措施的情况下构建自己的人工智能模型,这种方式既昂贵、耗时又困难,而是开始拥抱一种新趋势:越狱即服务。

大多数模型都附带了使用规则。越狱允许用户操纵人工智能系统来生成违反这些政策的输出——例如,编写勒索软件代码或生成可用于诈骗电子邮件的文本。

EscapeGPT 和 BlackhatGPT 等服务提供对语言模型 API 的匿名访问以及经常更新的越狱提示。为了对抗这个不断增长的家庭手工业,OpenAI 和谷歌等人工智能公司经常不得不堵塞可能导致其模型被滥用的安全漏洞。

越狱服务使用不同的技巧来突破安全机制,例如提出假设性问题或用外语提问。试图防止其模型行为不当的人工智能公司与想出更具创意的越狱提示的恶意行为者之间一直存在着一场猫捉老鼠的游戏。

钱卡利尼说,这些服务正为犯罪分子提供便利。

“持续越狱是一项乏味的活动。你想出了一个新的,然后你需要测试它,然后它会工作几周,然后 Open AI 更新他们的模型,”他补充道。 “对于犯罪分子来说,越狱是一项超级有趣的服务。”

人肉搜索和监视

Balunović 表示,人工智能语言模型不仅是网络钓鱼的完美工具,也是人肉搜索(泄露在线某人的私人识别信息)的完美工具。这是因为人工智能语言模型是根据大量互联网数据(包括个人数据)进行训练的,并且可以推断出某人可能所在的位置等。

作为其工作原理的示例,您可以要求聊天机器人假装是具有侧写经验的私家侦探。然后你可以要求它分析受害者所写的文本,并从文本中的小线索推断出个人信息,例如,根据他们上高中的时间推断他们的年龄,或者根据他们在通勤时提到的地标推断他们的居住地点。互联网上有关他们的信息越多,他们就越容易被识别。

Balunović 是一支研究团队的成员,该团队去年年底发现,大型语言模型(例如 GPT-4、Llama 2 和 Claude)能够仅从与聊天机器人的日常对话中推断出人们的种族、位置和职业等敏感信息。理论上,任何有权访问这些模型的人都可以以这种方式使用它们。

自他们的论文发表以来,利用语言模型这一特性的新服务已经出现。

虽然这些服务的存在并不表明存在犯罪活动,但它指出了恶意行为者可以利用的新功能。巴卢诺维奇说,如果普通人能够构建这样的监控工具,国家行为者可能会拥有更好的系统。

“我们防止这些事情发生的唯一方法就是加强防御,”他说。

他补充说,公司应该在数据保护和安全方面进行投资。

对于个人而言,提高意识是关键。Balunović 表示,人们应该三思而后行,考虑自己在网上分享的内容,并决定是否愿意让自己的个人信息被用在语言模型中。

发表评论